Notícias

Home / Notícias

Como podemos ensinar a tecnologia a não ser racista

A adesão dos diferentes tipos de mercados ao uso de ferramentas de biometria facial é um tópico que vem sendo debatido cada vez mais dentro da grande mídia. Esse tipo de tecnologia, que, de acordo com Allied Market Research, deve movimentar uma soma de mais de R$ 50 bilhões em 2022, é prática, eficiente e pode ser aplicada nos mais diversos setores da indústria, como na Saúde, com o monitoramento ativo dos pacientes para entregar soluções mais assertivas e humanizadas; em empresas, na gestão de pontos de funcionários; e no setor de Segurança Pública, ajudando a identificar foragidos da justiça. No entanto, na mesma medida em que esses sistemas se desenvolvem e multiplicam, devemos ficar atentos à maneira como ensinamos as máquinas, para que não se tornem parte de um mecanismo de retroalimentação de uma sociedade desigual e, muitas vezes, racista.

Assim como dito anteriormente, uma das aplicações da tecnologia de Reconhecimento Facial está no setor de Segurança Pública. Diferentes regiões e estados do país, como a Bahia, têm investido na incorporação dessa tecnologia para servir como aliada no trabalho dos profissionais da área de segurança, realizando, a partir das câmeras instaladas em locais públicos, a identificação de suspeitos e foragidos. No entanto, também tem se mostrado recorrente os casos de falha e equívoco que esses sistemas apresentam ao analisar a face de pessoas e contribuir com investigações. Recentemente, tivemos um caso inusitado no qual o ator norte-americano, Michael B. Jordan, conhecido por sucessos como “Creed” e “Pantera Negra”, foi indicado, erroneamente, como um dos suspeitos de participar de uma chacina que ocorreu no Ceará. A foto do ator esteve ao lado dos suspeitos de cometer o crime.

Esse é um caso que ganhou notoriedade e que foi tratado por muitos por um viés cômico, porém, ressalta muito bem o impacto que a tecnologia de Reconhecimento Facial pode causar social e legalmente, principalmente à população negra e asiática, se não for ensinada da maneira correta. Em um país como o Brasil, no qual a maioria da população carcerária é composta por pessoas negras, a porcentagem da população prisional que se considera negra é de 66,3%, como revela o 15º Anuário Brasileiro de Segurança Pública, divulgado em 2021 pelo Fórum de Segurança Público, é importante fazer um exercício crítico e avaliar como podemos implementar nossos softwares de uma maneira que não sirva para aumentar esses números equivocadamente.

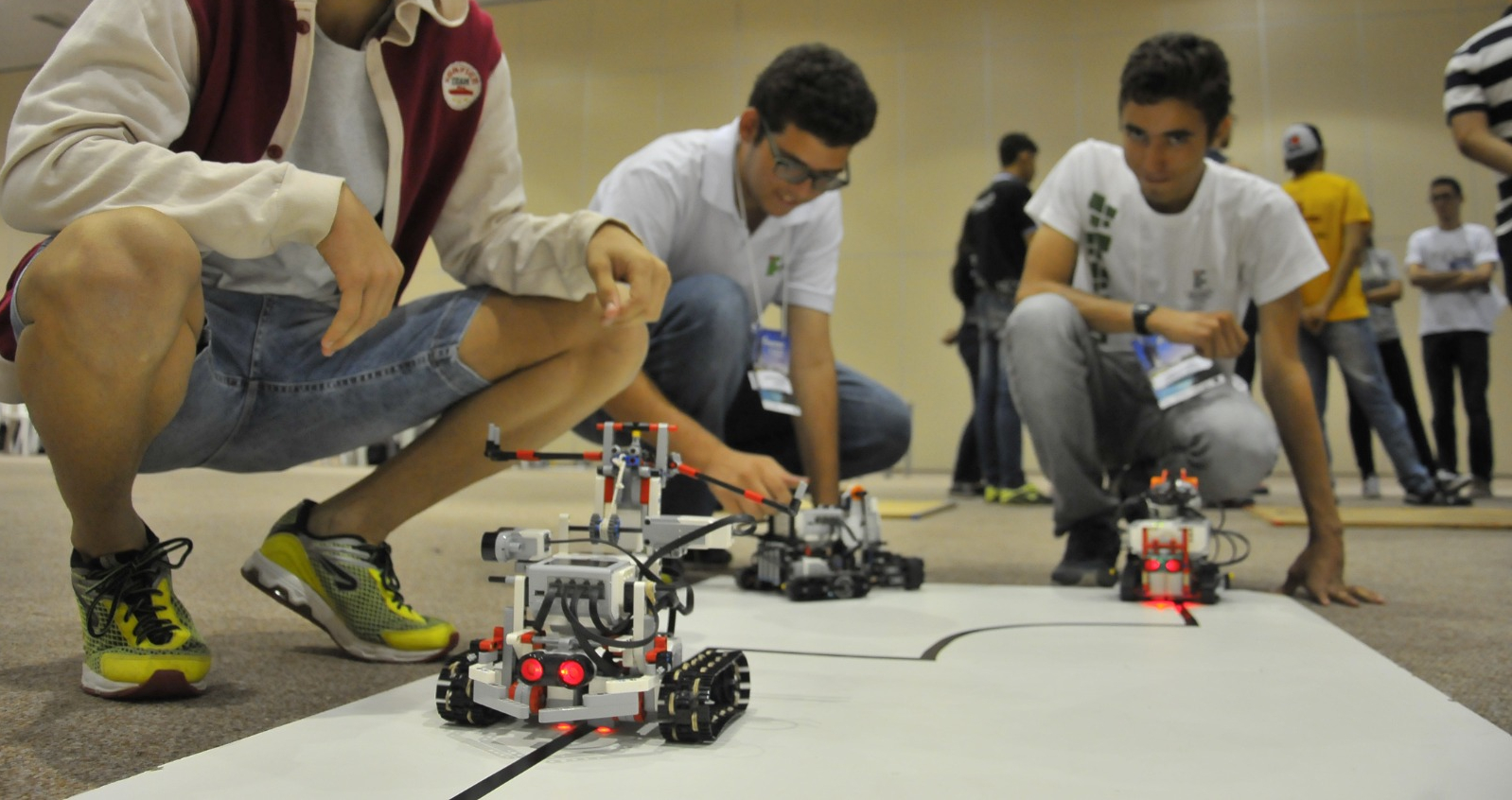

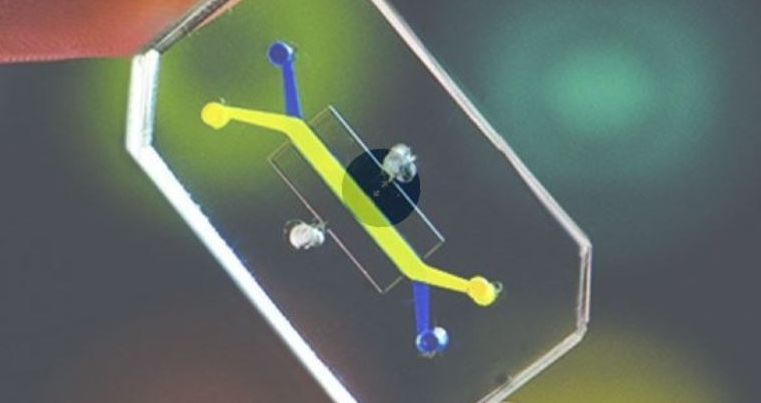

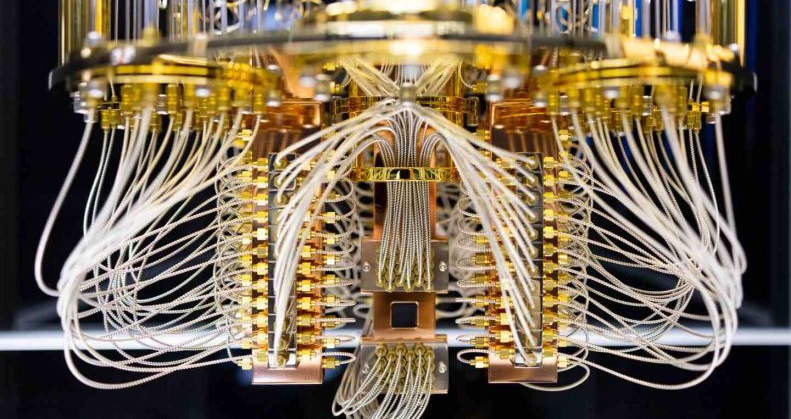

Antes de falar sobre o motivo das falhas e o que podemos fazer para preveni-las, é importante abordar como funciona a Biometria Facial. O Reconhecimento Facial é uma tecnologia desenvolvida com o propósito de identificar pessoas a partir de padrões da face. Isso é feito por meio do uso de Inteligência Artificial, que, por sua vez, é desenvolvida e alimentada através de machine learning, o processo de aprendizado da máquina. A tecnologia utiliza algoritmos matemáticos para analisar os diferentes pontos da face, específicos para cada indivíduo. O resultado desse processo é um código capaz de identificar a pessoa.

O problema que analisamos nessa conversa acontece justamente no processo de aprendizado das máquinas, o machine learning. Muitas empresas que trabalham com o desenvolvimento de programas de Reconhecimento Facial utilizam um banco de imagens com pouca diversidade, compostos, na maioria das vezes, por homens e mulheres brancos. A falta de repertório necessário para o processo de mapeamento das faces é o que causa o problema em debate. Muitas vezes, as máquinas que foram viciadas em um único viés entregam matchs errados ou são incapazes de analisar rostos negros ou asiáticos, por exemplo.

O resultado de tudo isso já pode ser visto, não apenas no Brasil, como também no restante do mundo. Casos de acusações e prisões injustas trazem um impacto físico e moral em quem é prejudicado por sistemas que foram desenvolvidos de maneira enviesada. Não apenas isso, mas em um país miscigenado como o Brasil, não incluir a diversidade de faces que nos cercam é negar o acesso da população às tecnologias e ferramentas que vão ser fundamentais para o nosso futuro.

É válido ressaltar que as máquinas não têm nenhum tipo de consciência própria e, apesar do que a ficção científica indica, não devem ter, pelo menos em um futuro próximo. Portanto, cabe a nós, humanos por trás das telas, investirmos em sua aprendizagem. Faremos isso trazendo maior diversidade às suas referências e aos seus bancos de imagem. A igualdade também é um direito no ambiente virtual e devemos lutar por ela.

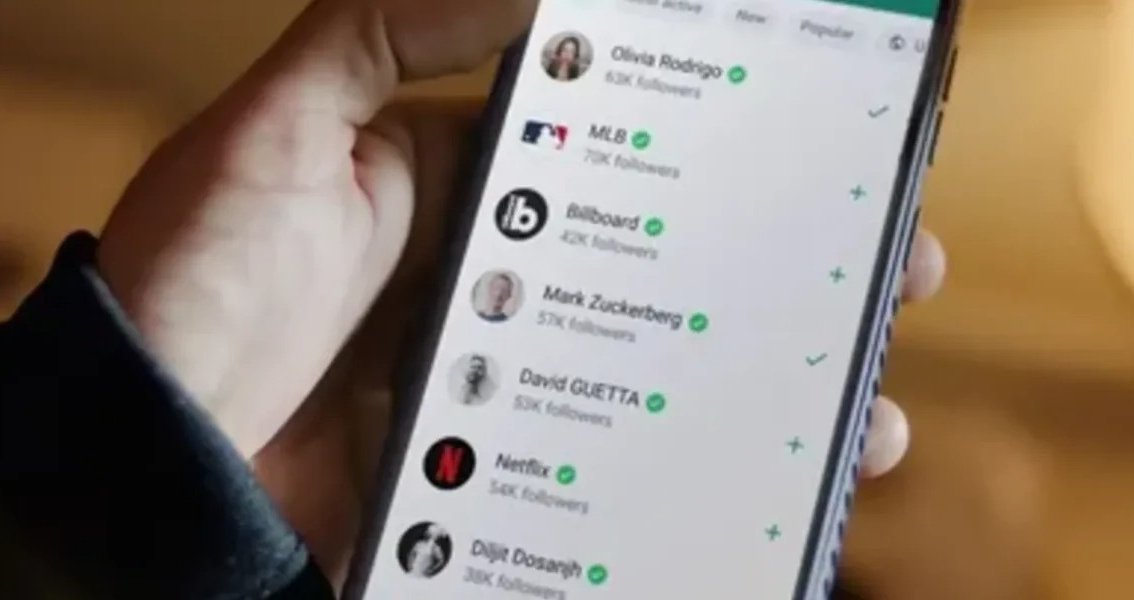

Para quem se interessou pelo debate, um bom material de estudo é o documentário Coded Bias (2020), disponível na Netflix.

Victor Gomes é CEO da Gryfo

Fonte: Olhar Digital

| Tags: tecnologia, racismo |

Artigos Relacionados a Matéria

Implantação de cabo de fibra ótica ligando Brasil a Europa começa na 2ª feira

#FiqueEsperto: ANID apoia campanha de conscientização sobre uso seguro da internet

Aplicativo do Google melhora comunicação para pessoas com deficiência de fala

Metade dos alunos de escolas públicas do país continuam sem ter conexão à internet.

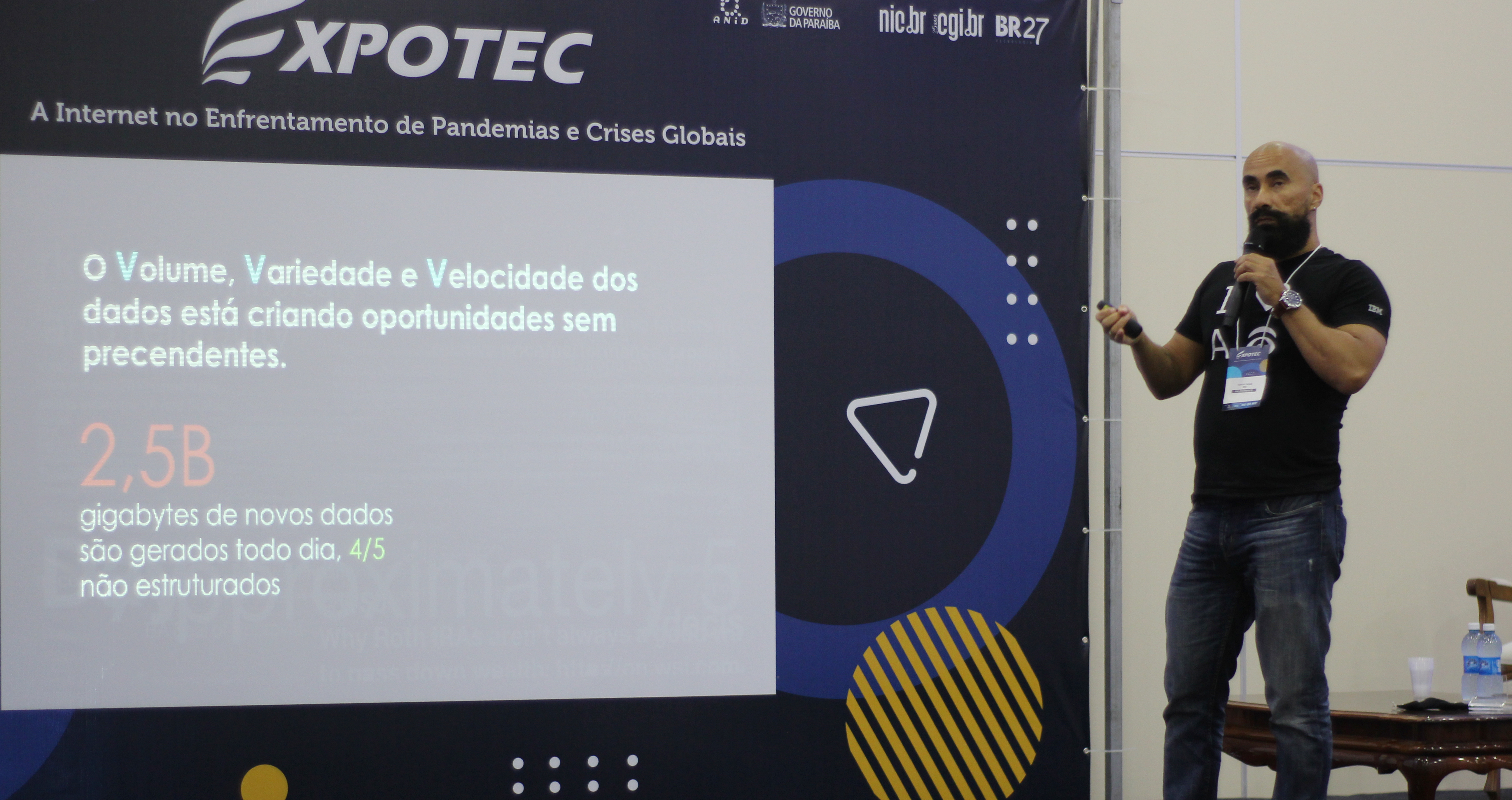

Evento traz reflexões sobre o que o mundo pós-Covid reserva para os negócios

Brasil é o 5º país com mais redes de câmeras de vigilância com reconhecimento facial no mundo

Pesquisadores do Google encontraram duas falhas no app de conferências do Zoom

ANID firma parceria com a SEPPM de João Pessoa para promover inclusão à mulheres

ANID firma parceria com a SEPPM de João Pessoa para promover inclusão à mulheres

Presidente da ANID participa de reunião do Governo Estadual com a Ministra Luciana Santos

Carta é feita com idealizações da Juventude sobre a cultura e inclusão digital

Seminário de Comunidades e Povos Tradicionais acontece no último dia da EXPOTEC 2024

Seminário de Comunidades e Povos Tradicionais será realizado na 10ª edição da Expotec

Nova IA da OpenAI supera humanos em testes de QI e impressiona com raciocínio avançado

Levitação da água: tecnologia inovadora abre novas possibilidades para a ciência

Nova Tecnologia Permite “Escrever” Átomos em Materiais para Dispositivos Quânticos

Nova versão do ChatGPT pode transformar a relação entre humanos e IA, mas gera incertezas

Nobel de Física Expressa Preocupações com os Avanços Rápidos na Inteligência Artificial

SpaceX realiza 2º voo completo da Starship, nave mais poderosa do mundo, neste domingo

Robô Optimus da Tesla impressiona ao interagir com público no evento “We, Robot”

O que aconteceria se uma super tempestade solar atingisse a Terra na era da internet?

Eletrônica viscosa: Elétrons não fluem como bolinhas, mas como um fluido viscoso

China adapta modelo de IA da Meta para aplicações militares, aponta relatório

O maior evento sobre o futuro da internet já passou por João Pessoa. O próximo será na Noruega

Cientista brasileiro descobre nova propriedade dos lasers: projeção de sombras

Brasil ainda tem muito a evoluir na cibersegurança — e essa tecnologia pode ajudar

Smash 2024: Paraibano entre os participantes de um dos maiores eventos de tecnologia do Brasil

Para além do ChatGPT: o futuro da Inteligência Artificial segundo os líderes da tecnologia

Smash 2024: Presidente da ANID participa de um dos maiores eventos de tecnologia do Brasil

Travamento Misterioso do ChatGPT: Navegando na Privacidade e Transparência na IA

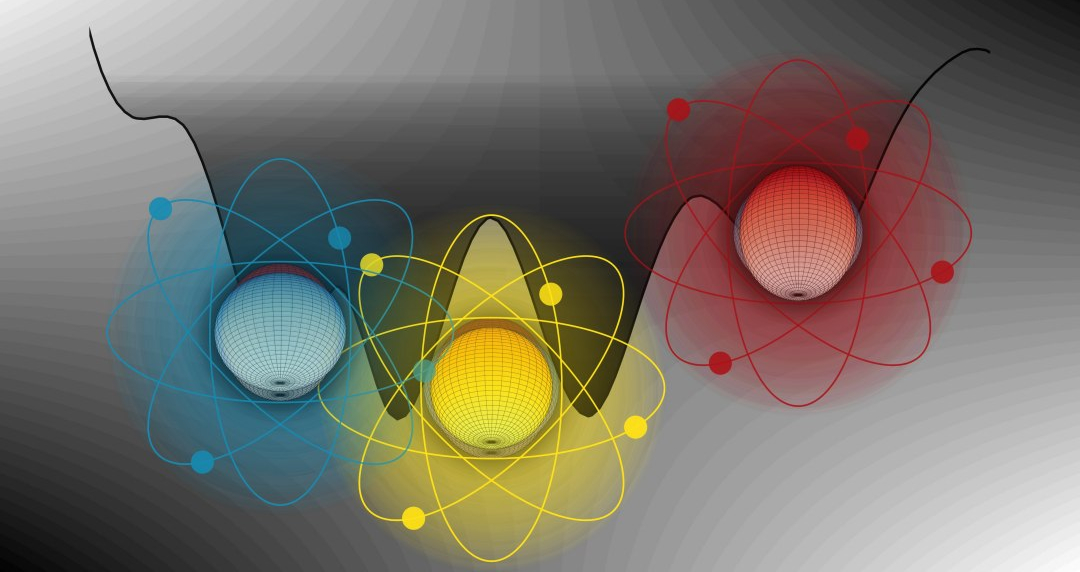

Visão inédita dos nêutrons ajuda a entender ainda mais a composição da matéria

Da Pedra à Inteligência Artificial: Uma Jornada pela Evolução Tecnológica da Humanidade

Expectativa de vida do brasileiro sobe para 76,4 anos e super índice pré-pandemia

Segurança Cibernética do Brasil Exibe Fragilidades e Compromete a Soberania Digital

TV 3.0 promete transformar experiência televisiva com qualidade 4K e interatividade

Observação Direta de Três Formatos Diferentes no Núcleo Atômico Desafia Modelos de Física

As Alucinações da IA Não Podem Ser Eliminadas — Mas Técnicas Podem Limitar Seus Danos

DeepSeek: A IA chinesa que promete revolucionar o mercado e desafiar o ChatGPT

LGPD 2025: confira 6 dicas para adequar a sua empresa à Lei Geral de Proteção de Dados

Pele humana vira “bateria viva”: nova tecnologia permite carregar dispositivos pelo corpo

OpenAI Lança Modelo de IA Gratuito em Resposta à Concorrência com Startup Chinesa”